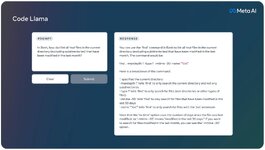

Meta ปล่อย Code Llama โมเดลปัญญาประดิษฐ์ที่พัฒนาต่อจาก Llama2 มาฝึกกับซอร์สโค้ดขนาด 500 ล้านโทเค็น ได้โมเดลทั้งแบบเติมโค้ดปกติ, แบบรับคำสั่ง, และโมเดลฝึกเฉพาะกับโค้ด Python

ผลทดสอบการเขียนโค้ด HumanEval นั้น Code Llama ขนาด 34B ได้คะแนนดีกว่าโมเดลอื่นๆ ทั้งหมด รวมถึง GPT-3.5 หรือ ChatGPT ด้วย เป็นรองเพียง GPT-4 เท่านั้น ขณะที่โมเดลขนาดรองลงมา เช่น 7B และ 13B ก็ยังทำคะแนนได้ดีและตอบสนองเร็วกว่ามาก

กระบวนการฝึก Code Llama นั้นเน้นถึงการเติมโค้ดตรงกลางเพิ่มเข้ามา เนื่องจากการใช้งานมักต้องใช้สำหรับ code completion ด้วย และต้องฝึกให้ขยาย context จาก 4K เป็น 100K เพื่อให้เพียงพอสำหรับการเขียนโค้ดขนาดใหญ่ๆ

Meta อนุญาตให้ใช้งานโมเดล Code Llama ได้ฟรีโดยจำกัดไม่ให้องค์กรที่มีผู้ใช้เกิน 700 ล้านคนต่อเดือนใช้งานแบบเดียวกับ Llama 2

ที่มา - Meta

Topics:

Meta

Artificial Intelligence

LLM

อ่านต่อ...

ผลทดสอบการเขียนโค้ด HumanEval นั้น Code Llama ขนาด 34B ได้คะแนนดีกว่าโมเดลอื่นๆ ทั้งหมด รวมถึง GPT-3.5 หรือ ChatGPT ด้วย เป็นรองเพียง GPT-4 เท่านั้น ขณะที่โมเดลขนาดรองลงมา เช่น 7B และ 13B ก็ยังทำคะแนนได้ดีและตอบสนองเร็วกว่ามาก

กระบวนการฝึก Code Llama นั้นเน้นถึงการเติมโค้ดตรงกลางเพิ่มเข้ามา เนื่องจากการใช้งานมักต้องใช้สำหรับ code completion ด้วย และต้องฝึกให้ขยาย context จาก 4K เป็น 100K เพื่อให้เพียงพอสำหรับการเขียนโค้ดขนาดใหญ่ๆ

Meta อนุญาตให้ใช้งานโมเดล Code Llama ได้ฟรีโดยจำกัดไม่ให้องค์กรที่มีผู้ใช้เกิน 700 ล้านคนต่อเดือนใช้งานแบบเดียวกับ Llama 2

ที่มา - Meta

Topics:

Meta

Artificial Intelligence

LLM

อ่านต่อ...